过去几年,随着基于人类偏好的强化学习(Reinforcement Learning from Human Feedback,RLHF)的兴起,强化学习(Reinforcement Learning,RL)已成为大语言模型(Large Language Model,LLM)后训练阶段的关键技术。RL 不仅显著提升了模型的对齐能力,也拓展了其在推理增强、智能体交互等场景下的应用边界。围绕这一核心范式,研究社区不断演化出多种优化策略和算法变体,如 Agentic RL、RLAIF、GRPO、REINFORCE++ 等。这些新兴范式虽然形式各异,但底层需求高度一致:几乎都涉及多模块协同(Actor、Critic、Reward、Ref)与多阶段流程(生成、推理、训练)的高效调度。这也对训练框架提出了更高的要求:不仅要支持大规模模型的高效训练,还需具备良好的可扩展性与开发友好性。因此,一套真正高效、可扩展且用户友好的 RL 系统框架,成为业界刚需。

近日,淘天集团携手爱橙科技正式开源了全新一代强化学习训练框架 ROLL(Reinforcement Learning Optimization for Large-scale Learning)。ROLL 以用户体验为核心设计理念,专为「高效・可扩展・易用」而打造,彻底打通从小模型到 600B+ 超大模型的 RL 训练落地路径。

ROLL 在诸如人类偏好对齐、复杂推理和多轮自主交互场景等关键领域显著提升了大语言模型的性能,同时具备超高的训练效率,目前 ROLL 已成功应用在多个淘天集团内部业务场景, 为业务创新提供了强大的技术支持。

- 开源项目:https://github.com/alibaba/ROLL

- 论文标题:Reinforcement Learning Optimization for Large-Scale Learning: An Efficient and User-Friendly Scaling Library

- 论文地址:https://arxiv.org/pdf/2506.06122

总体而言,ROLL 具有以下关键特性:

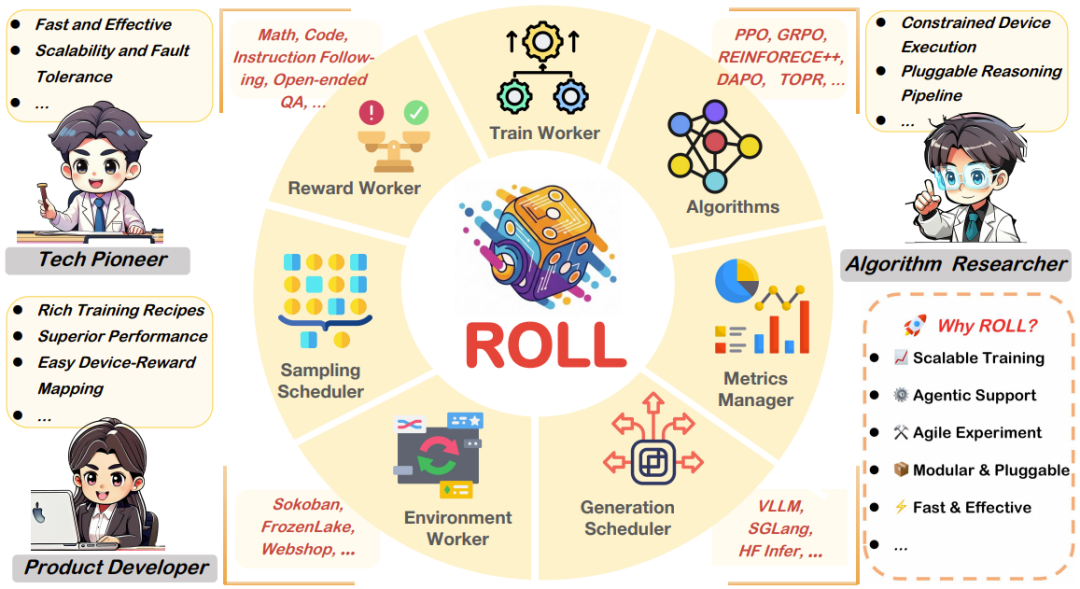

- 多任务强化学习:内置丰富的 RL 任务支持,涵盖数学、代码、通用推理、开放式问答、指令遵循等,一套训练循环即可多领域联合优化,采样率与数据权重可灵活动态调整。

- 智能体强化学习(Agentic RL):原生支持多环境、多角色智能体 - 环境交互(游戏、多轮对话等),并具有灵活的并行化和内置管理功能,可满足多种任务需求。

- 算法友好:提供灵活且丰富的 RL 策略配置,包括但不限于多种减小方差的 baseline、不同奖励标准化方式和 data mask 策略等,同时也开箱即用地支持 PPO、GRPO、Reinforce++ 等算法。

- 丰富的训推引擎:灵活支持 vLLM、SGLang、Megatron-Core、DeepSpeed 等主流推理 / 训练引擎, 参数透传,无需修改底层代码直接适配不同版本。

- 弹性资源调度与分布式并行:基于 Ray 的多角色分布式架构,灵活资源分配,训练无缝支持 MegatronCore 5D (DP / TP / PP / CP / EP)并行高效利用异构硬件,从单机到千卡集群均能轻松运行。

- 极致易用与模块化扩展:Rollout Scheduler、AutoDeviceMapping 等关键模块极大简化 pipeline 开发和调试,支持按需组合套件,后端推理 / 训练引擎自由切换。

- 样本级调度与动态采样:样本级 Rollout 生命周期调度机制,支持异步奖励计算、动态采样、按样本裁剪与 EarlyStopping,显著提升训练效率与资源利用率。

- 可观察性:集成了 wandb / swanlab / tensorboard,支持实时跟踪每个领域、每个策略、每个奖励的性能 —— 从高层概况到细粒度诊断。

目前,该项目已经在 GitHub 上收获了 1000+ star。

面向用户友好设计的 ROLL

ROLL 是一款面向用户友好设计的强化学习框架。具体来说,ROLL 从一开始就考虑了三类用户诉求,即:技术先驱者、产品开发者和算法研究者。

- 对于技术先驱者,支持异构大规模 GPU 集群下的弹性扩展与容错,能够在上千卡环境下持续稳定地完成 600B+ 大模型训练,极大降低训练成本和中断风险。

- 对于产品开发者,可灵活配置奖励函数、环境、采样比例与数据配比,轻松实现各种任务场景的 RL 训练落地。

- 对于算法研究者,单卡 / 少卡资源下也能高效实验,所有模块高度抽象,极易实现自定义 RL 算法、奖励与环境,极大缩短从想法到验证的周期。

ROLL 针对三大用户群体设计

ROLL 的技术细节

那么,ROLL 是如何做到的呢?具体来说以下多项创新:

- 基于《Hybridflow: A flexible and efficient rlhf framework》中提出的单控制器架构,该团队引入了定义良好的并行工作器(Parallel Worker)抽象,可实现灵活且模块化的强化学习训练流程,从而简化了新想法的实验过程。

- 引入了优化后的并行策略(Parallel Strategy)和数据传输(Data Transfer)模块,从而可以在资源受限设备上执行,还能实现快速、可扩展且容错的训练。

- 为了在生成阶段对每个提示词样本的生命周期进行细粒度的管理,

- 该团队提供了 Rollout 调度器,可以简化响应生成、环境交互和奖励计算之间的流程编排。该团队专门设计了环境(Environment)工作器和奖励(Reward)工作器,可以提供高效且可扩展的智能体环境交互和奖励计算。该团队还实现了资源池(Resource Pool),并利用了 AutoDeviceMapping 来实现高效的工作器调度和资源的优化分配。

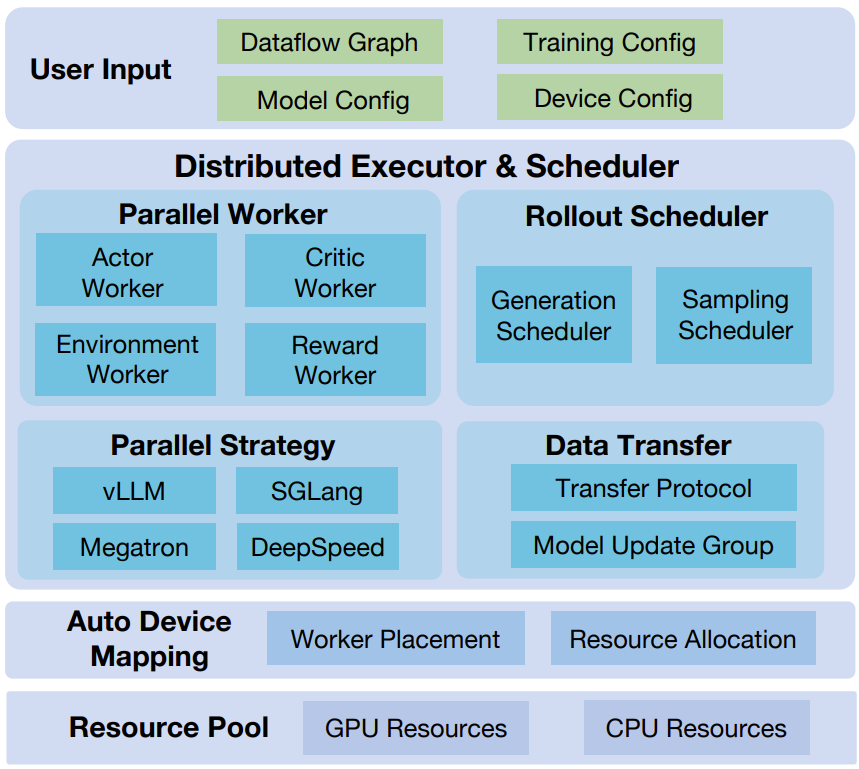

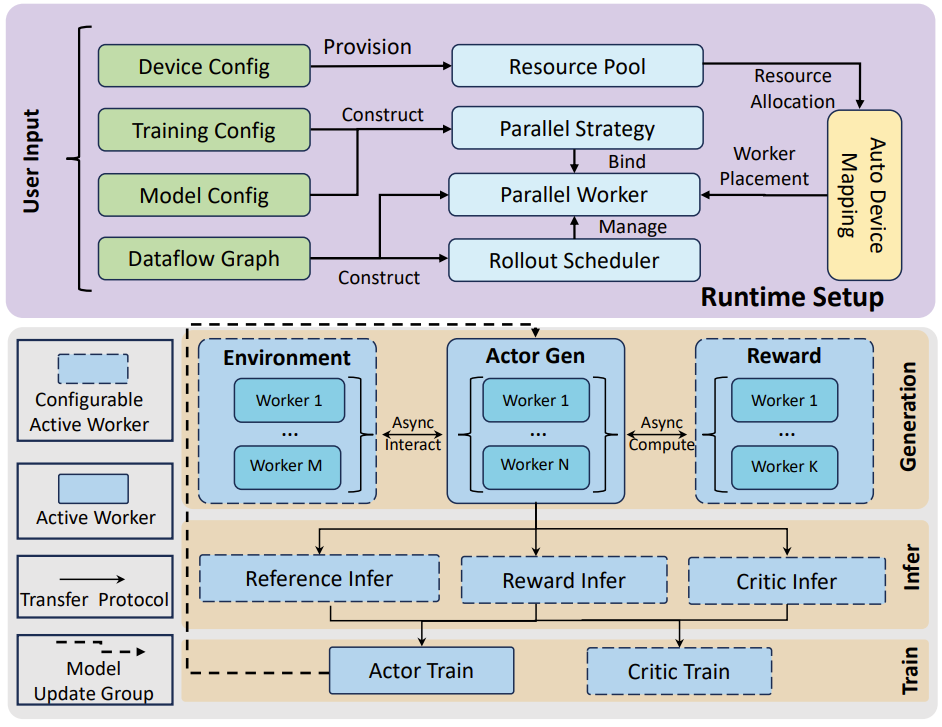

下图展示了 ROLL 的整体架构。ROLL 接收的输入是用户定义的强化学习数据流及其相关配置。基于这些输入,分布式执行器和调度器可协调管理各类工作节点和调度节点。 而 AutoDeviceMapping 模块则负责管理已分配资源池中的计算资源,并高效地将工作节点和调度节点绑定到其分配的资源上。

ROLL 的架构,由用户输入层、分布式执行器和调度器、Auto Device Mapping 模块以及资源池组成。

而在运行时,ROLL 首先会根据提供的设备配置,分配由 GPU 和 CPU 资源组成的资源池。在 RL 数据流的指导下,系统会创建一个 Rollout 调度器和多个并行工作器。其中,Rollout 调度器负责管理生成阶段中每个提示词样本请求的生命周期。

然后,根据训练和模型配置,ROLL 会实例化并行策略,以决定每个并行工作器的并行策略和执行后端。一旦并行工作器建立完成,ROLL 将依据用户指定的设备映射配置,调用 AutoDeviceMapping 模块,从资源池中为各个并行工作器分配相应的计算资源。如下图所示。

ROLL 的运行时设置和训练工作流程。

接下来,进入训练迭代。在生成阶段,首先将一批样本送入 Rollout 调度器以生成响应。在此过程中,Actor 模型可能会与环境工作器进行交互,以实现智能体强化学习任务中的多轮环境互动。同时,系统也会调用奖励工作器来计算奖励信号,从而支持高级采样技术(例如动态采样)以提升采样效率。

在接下来的推理阶段,会执行 Critic、Reward 和 Ref 模型(前提是这些模块已在 RL 数据流图中启用)的前向传播。随后,迁移协议会对生成阶段输出的响应进行分片,并将其分发给各个活跃的并行工作器。

在训练阶段,Critic 和 Actor 模型利会用已准备好的奖励信号更新各自的参数。此外,在下一轮训练迭代中,Actor 模型还会通过 ModelUpdateGroup 与生成阶段同步模型参数,确保训练与生成过程的一致性。

另外,ROLL 也支持 wandb、swanlab、TensorBoard 等实验可视化方案。更多技术细节请访问原论文。

ROLL 的实验表现

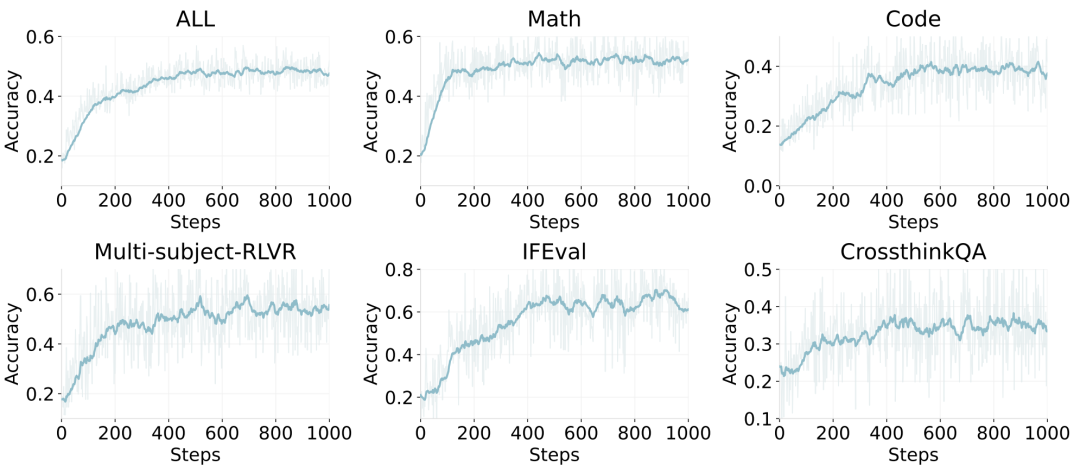

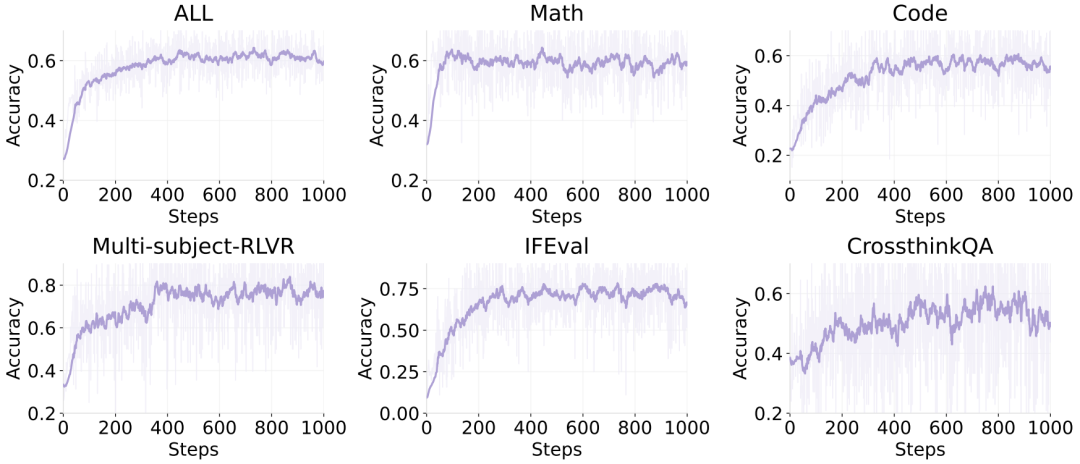

在 Qwen2.5-7B-base 与 Qwen3-30B-A3B-base 等模型上,ROLL 取得了显著的跨领域多任务性能提升。例如,在 RLVR pipeline 训练下,Qwen2.5-7B-Base 的整体准确率从 0.18 提升至 0.52(2.89 倍),Qwen3-30B-A3B-Base 准确率从 0.27 提升至 0.62(2.30 倍),这两个模型在 ROLL 的支持下均展现了稳定且一致的准确率提升,且未发生模型崩溃等异常现象,展现了 ROLL 极佳的稳健性和实用性。

Qwen2.5-7B-base 在不同领域上的准确度表现。

Qwen3-30B-A3B-base 在不同领域上的准确度表现。

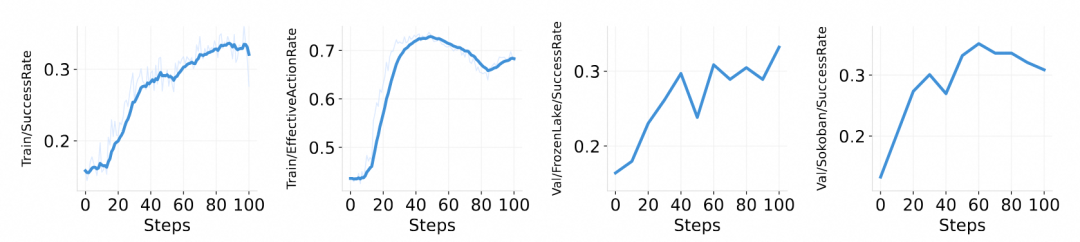

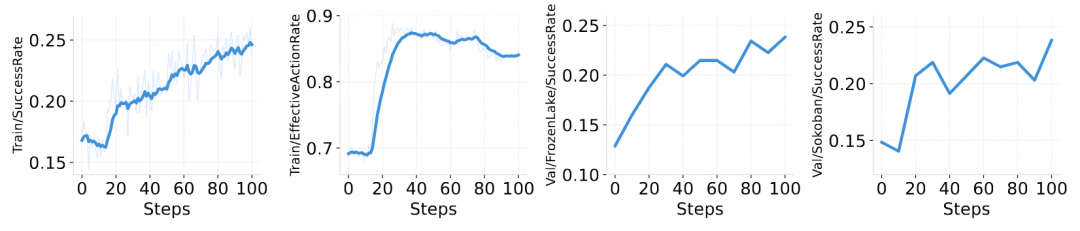

除了标准 RL 流程,ROLL 在智能体交互场景中同样展现了强大的稳健性。研发团队在三个典型环境下对 ROLL 的泛化性与适应性进行了实证验证:

- Sokoban(推箱子):在经典网格推箱子任务中,模型在训练集上的成功率从 16.8% 提升至 26.0%,验证集成功率从 13.3% 提升至 35.2%。表明智能体在多轮决策与空间规划方面能力显著增强。此外,该训练结果具备良好的跨任务迁移能力,能有效泛化至其他环境如 FrozenLake。

在 SimpleSokoban 环境训练的性能变化趋势,SuccessRate 表示达到目标的成功率 EffectiveActionRate 表示执行有效动作的比例。

- FrozenLake(冰冻湖): 训练成功率从 16.8% 提升至 26.0%,有效动作占比从 69.1% 提升至 88.8%;验证集成功率也从 12.9% 升至 23.8%。

在 FrozenLake 环境训练的性能变化趋势。

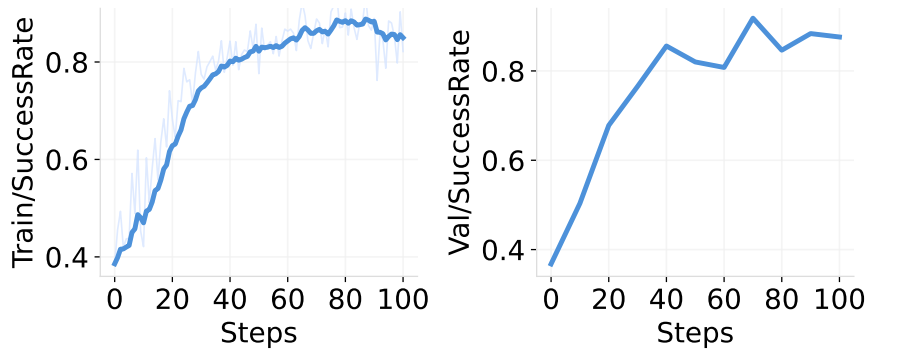

- WebShop(网页购物):在模拟真实购物任务中,训练和验证集上的成功率从 37% 大幅提升至超过 85%。同时,平均每轮交互动作数从 7 降至 4,表明模型在复杂自然语言指令下逐步学会了高效完成目标任务,体现出较佳的操作效率和指令理解能力。

在 WebShop 环境上的准确度趋势。

ROLL 仍在进化

ROLL 已在 GitHub 上线,并在短时间内收获大量 star。项目仍在持续迭代,未来将支持 Qwen2.5 VL Agentic RL、一步式异步 pipeline、FSDP2、DeepSeekV3 等新特性,欢迎关注并参与共建。

- 项目主页:https://github.com/alibaba/ROLL

- 论文介绍:https://arxiv.org/pdf/2506.06122

开源精神是推动技术发展的核心引擎,ROLL 研发团队期待更多优质人才加入。这里既有技术攻坚的硬核挑战,也有共创未来的无限可能。

热招岗位:

- PostTrain 框架研发工程师:https://talent-holding.alibaba.com/off-campus/position-detail?lang=zh&positionId=7000016304

- 大模型训练算法专家:https://talent.taotian.com/off-campus/position-detail?lang=zh&positionId=1217103

顺带一提,淘天集团第四届技术节【硬核少年技术节 4.0】将于 2025 年 6 月 30-7 月 4 日在北京和杭州两地隆重举办。本届技术节持续一周,包含技术市集、博见社、Openday、AI 狼人杀、AI Hackathon 比赛等各类丰富多彩的 AI 展示场、AI 交流场、AI 开放场、AI 比赛场。

7 月 2 日下午 14:00,此次技术节的重磅 AI 交流场 ——【博见社】,将进行「多模态智能」方向的专场主题分享和「多模态智能与 AI Agent」的圆桌交流,嘉宾包括中科院自动化所研究员刘静、哈尔滨工业大学计算机学院长聘教授左旺孟、南京大学计算机学院教授王利民、清华大学计算机系副教授刘知远、中国人民大学准聘副教授李崇轩等学者。欢迎大家预约直播观看。

文章来自于微信公众号“机器之心”。