哦豁,OpenAI奥特曼又痛失一员大将。

Kevin Lu,领导4o-mini发布,并参与o1-mini、o3发布,主要研究强化学习、小模型和合成数据。

下一站是Thinking Machine Lab,OpenAI前CTO Mira Murati出走后新创立的AI公司,估值已达120亿美元。

不完全统计,Thinking Machine Lab已经集结数位OpenAI前核心研究员,包括John Schulman、Barrett Zoph、翁荔等。

从Meta到OpenAI,再离开

Kevin Lu毕业于UC伯克利,主要研究强化学习和离线序列数据建模。

毕业后先后加入Hudson River Trading和Meta,2024年3月加入OpenAI。

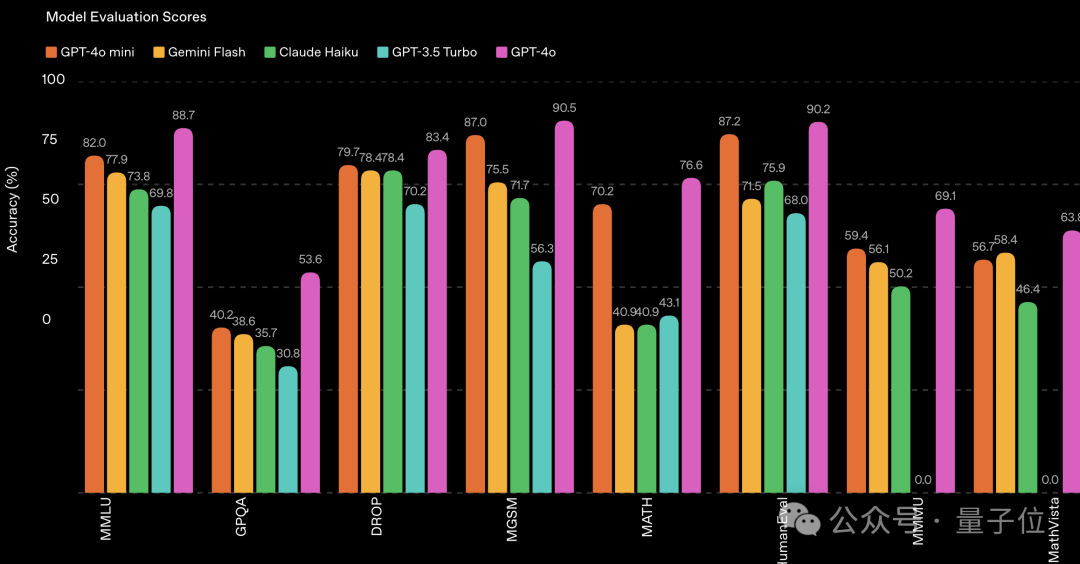

入职3个月后领导团队完成了4o-mini,这是一个多模态推理小模型。支持图文输入、长上下文,适合复杂任务;同时速度更快、成本更低。

此外还参与了o1-mini和o3的模型开发。主要擅长的领域应该是小模型和强化学习。

其引用量最高的一篇论文是《决策Transformer:通过序列建模进行强化学习》,引用量2254。

这篇论文发表于2021年,研究团队集结了UC伯克利、Meta AI、UCLA、OpenAI和Google Brain。

这是一个将强化学习问题视为条件序列建模的架构,通过将自回归模型基于期望回报(奖励)、过去的状态和动作进行条件化,决策Transformer能够生成期望回报的未来动作。

近期,Kevin Lu的一篇与他主要研究领域相关的博客还有点出圈:互联网才是唯一重要的技术。

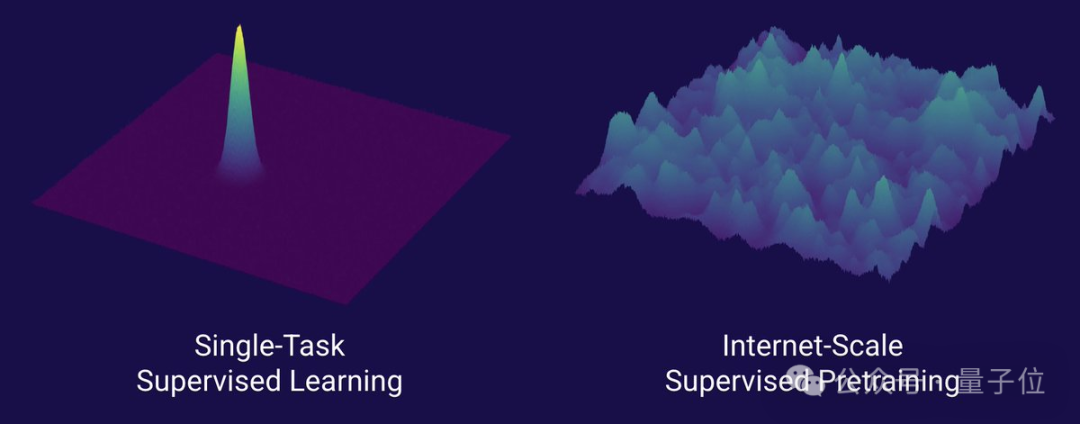

他认为现在对Transformer架构的关注有点过高了,真正重要的还是数据。研究者们应该关注如何从互联网这样的数据源中学习和预测,因为互联网提供了大量序列相关数据,非常适合进行“下一个token预测”。

在少量数据的环境里,Transformer将失去价值。

以及现在强化学习难以实现从GPT-1到GPT-4般的重大突破,应该停止进行强化学习研究,将注意力放在产品开发上。

强化学习的未来可能涉及到新的数据源和奖励机制创新,这可能是AI研究的新方向。

刚刚完成20亿美元种子轮融资

Kevin Lu的下一站Thinking Machine Lab,也是AI领域近期讨论度最高的初创公司之一。

它由OpenAI前CTO Mira Murati联合多位OpenAI前成员成立。

除了Mira本人外,团队核心成员已经覆盖AI领域目前的主要方向:

- John Schulman,OpenAI联创,ChatGPT架构师

- Barrett Zoph,OpenAI前研究副总裁,后训练专家

- 翁荔,OpenAI前AI安全系统负责人,专长AI安全

- Andrew Tulloch,擅长预训练&推理

- Luke Metz,专注后训练

- Alexander Kirillov,OpenAI前多模态研究负责人

- ……

以及新加入的Kevin Lu,擅长小模型和强化学习。

根据LinkedIn信息,Kevin Lu已于7月正式从OpenAI离职。几乎同时,Thinking Machine Lab完成破纪录种子轮融资,估值飙升到120亿美元。

而且在最近激烈的硅谷人才大战中,Thinking Machine Lab独善其身,十几名成员无人接受小扎offer,10亿美元薪酬都拒绝。

不过Thinking Machine Lab目前还未公开任何成果,倒是让人更加期待了。

参考链接:

[1]https://x.com/miramurati/status/1945166365834535247

[2]https://kevinlu.ai/

文章来自于微信公众号“量子位”,作者是“明敏”。